기존 샘플링의 문제점은 옛날 레코드는 사용하지 않는다는것.

Rejection sampling은 조건이 맞지 않으면 버렸다.

Important sampling은 개별 sample들이 다 독립이었다.

Inference 문제에서는 Z를 Assign 하는것이 핵심이다. 그러면 sampling을 통해 z를 assign 해보자.

E가 latent variable이면 sampling기반으로 optimize 해보자.

Random variable에 대해 assign을 하려하는데 process 형태로 해보자.

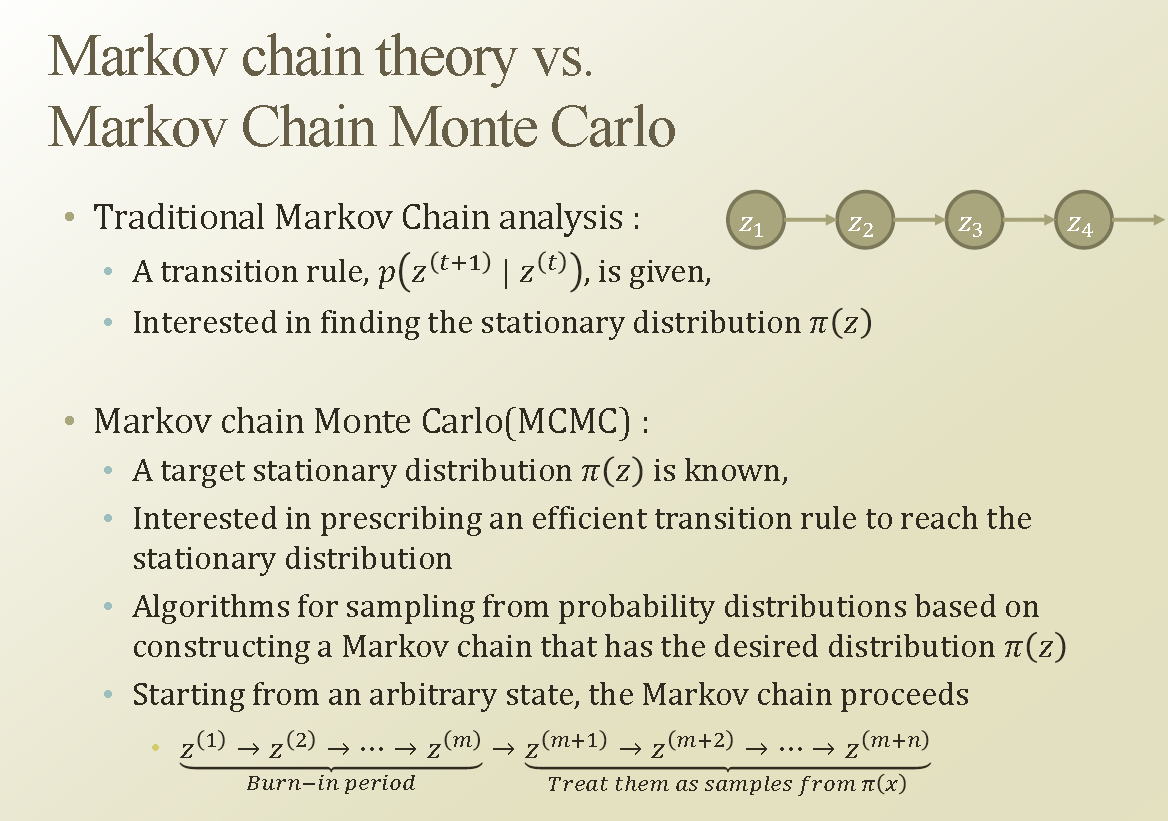

z1에서 assignment가 있었다고 해보자. 기존 정보를 활용해 다음번 정보에 활용하겠다는것이다. 이것이 Markob chain을 활용한 latent variable에대한 assignment 방식이다.

MCMC는 Stationary Distribution이 알려져 있다고 생각해보자. 그러면 Stationary Distribution을 만드는 Transtion Matrix는 무엇일까? 이것에 대해 관심있는것이 MCMC 이다.

Inference는 assignment 가 중요한데 ,transition matrix를 잘 만들어서 , 그것을 활용해서 sampling을 매 term 마다 해보자는것이 MCMC의 내용이다.

처음에는 마음대로 정한 assignment 를 지속적으로 다음 assignment에 참조해서 sampling을 통한 assignment를 쭉하면 , stationary distribution 과 유사해지지 않을까 하는것이 MCMC의 핵심내용이다.

'머신러닝 > 문일철 교수님 강의 정리 (인공지능및기계학습개론)' 카테고리의 다른 글

| 10.7 Gibbs Sampling (0) | 2020.01.01 |

|---|---|

| 10.6 Metropolis-Hastings Algorithm (0) | 2019.12.11 |

| Week 10.4 Markov Chain (0) | 2019.12.02 |

| Week 10.3 Importance Sampling (0) | 2019.11.28 |

| Week 10.2 Rejection Sampling (0) | 2019.11.27 |