Margin distance

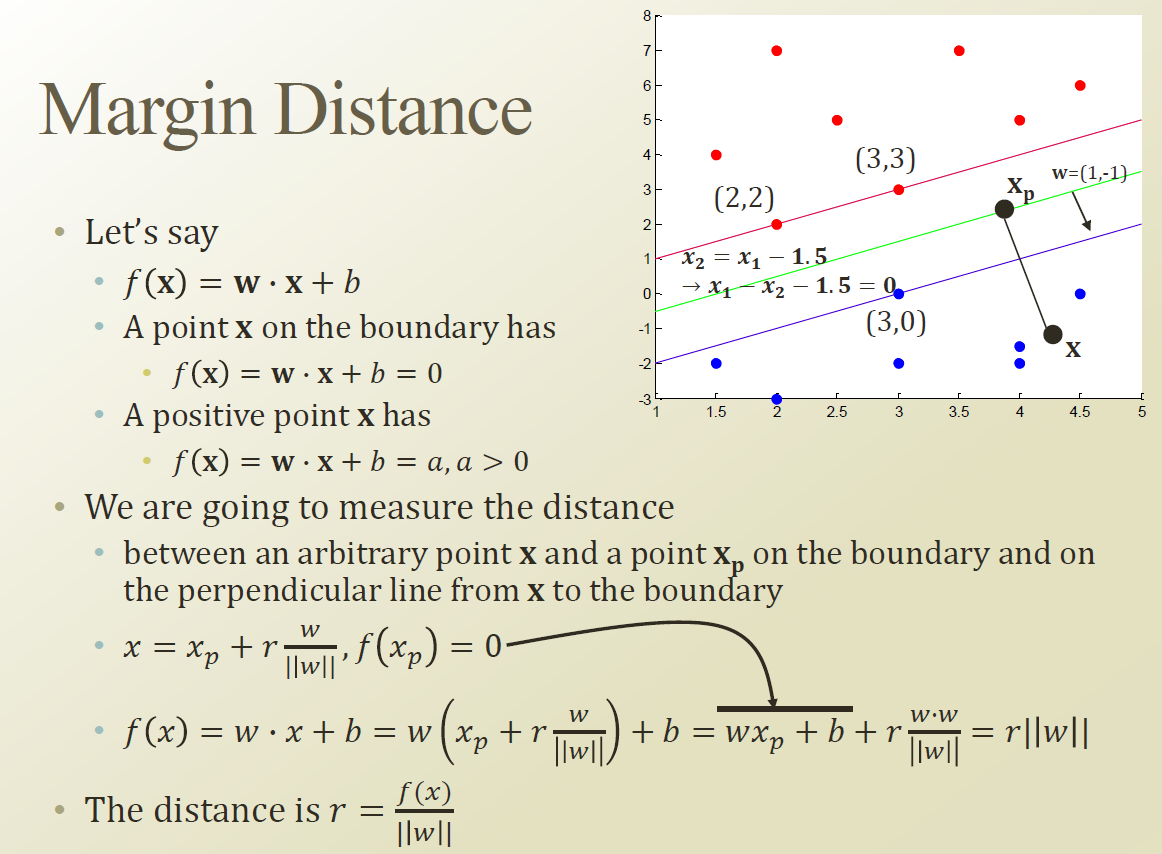

점이 DB 위에 있으면 wx+b =0 이다.

특정 point x 에서 DB로 수선의 발을 내려 만나는 점을 xp 라고 하자. xp는 DB 위에 있는점이 된다.

즉 x는 xp에서 w 벡터 방향으로 r만큼 진행한 거리가 될수 있다.

Margin distance 는 Optimize 해주는 방향으로 가면 구할수 있다.

Margin distance 는 Positive / Negative 두가지 방향이 있다.

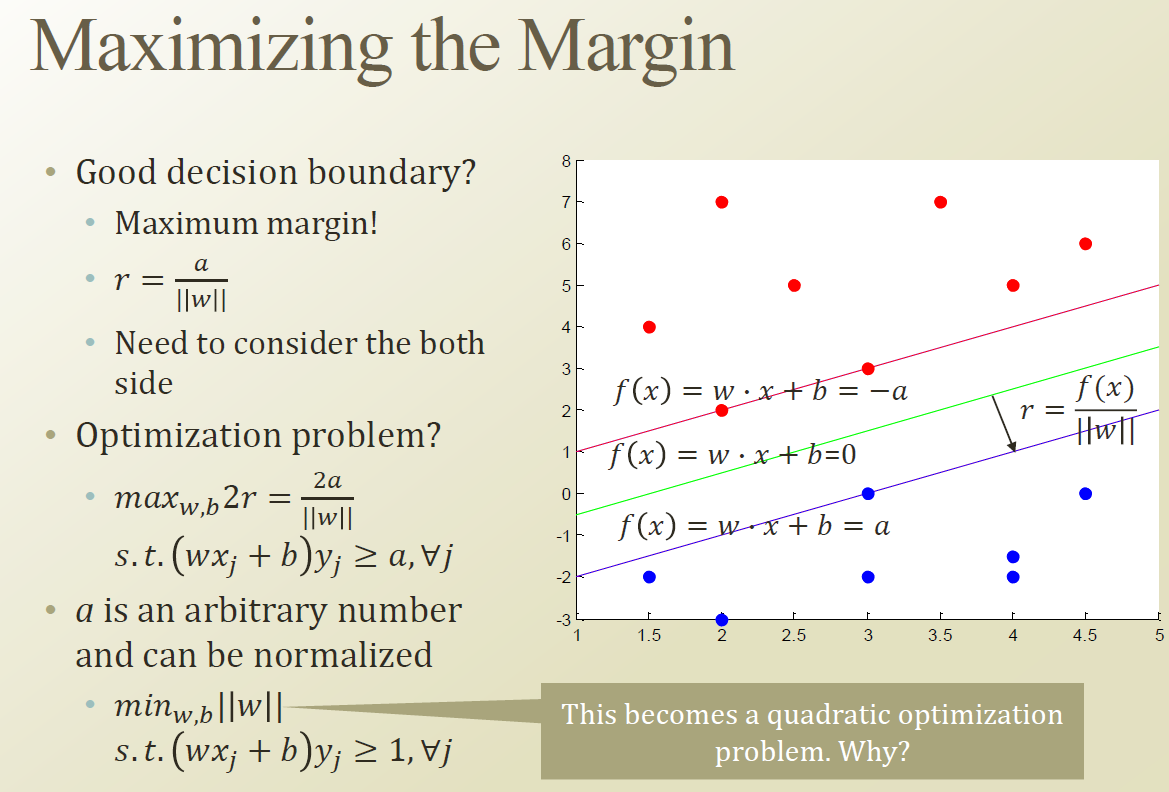

위의 식에서 j는 learning instance 이다. (Dataset의 각각의 instance , training set 이라고 할수 있다.)

위에서 a는 constane term으로 생각해서 1로 두어도 무관하다.

그리고 max 값을 구하는 문제를 역수로 두어 min 값을 구하는 것으로 변형해도 된다.

support machine 을 Learning 하는것은 parmeter를 inference 하는 과정이라 할수 있다.

w의 개별 element 가 w1 , w2 로 나누어지고 ||w|| 를 구하기 위해서는 w1^2+w^2 의 square term 이 들어가기 때문에 quadratic optimization 이라 할수 있다.

이것은 quadratic programing 을 통해 최적화 할수 있다.

'머신러닝 > 문일철 교수님 강의 정리 (인공지능및기계학습개론)' 카테고리의 다른 글

| Week 5.5. Soft Margin with SVM (0) | 2019.07.19 |

|---|---|

| Week 5.4. Error Handling in SVM : 서포트벡터 머신에서의 오류처리 (0) | 2019.07.19 |

| Week 5.1. Decision Boundary with Margin (0) | 2019.07.17 |

| Week 4.8 Naive Bayes vs Logistic Regression (0) | 2019.07.17 |

| Week 4.7. Naive Bayes to Logistic Regression (0) | 2019.07.08 |